AMD Instinct MI300X, TSMC'nin gelişmiş paketleme teknolojisi ve çiplet tasarımı ile üretildi. Oldukça etkileyici rakamlara sahip hızlandırıcının Nvidia H100 ile kıyaslamasına bakalım.

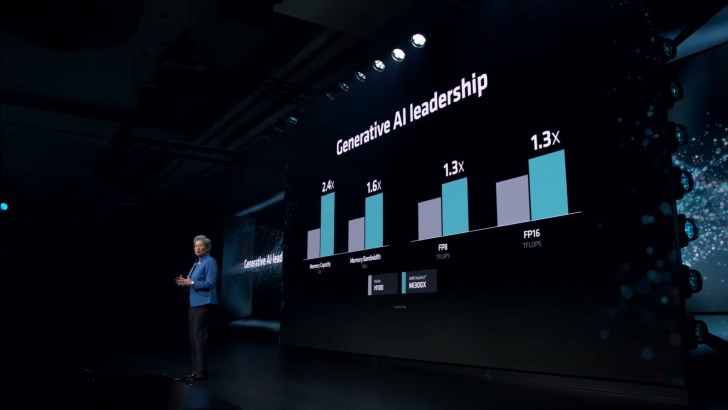

- 2.4 kat daha yüksek bellek kapasitesi

- 1.6 kat fazla bellek bant genişliği

- 1.3 kat fazla FP8 TFLOPS

- 1.3 kat fazla FP16 TFLOPS

- Llama 2 70B, birebir kıyaslamada %20'ye kadar daha hızlı

- FlashAttention 2, birebir kıyaslamada %20'ye kadar daha hızlı

- Llama 2 70B, 8v8 sunucuda %40'a kadar daha hızlı

- FlashAttention 2, 8v8 sunucuda %60'a kadar daha hızlı

Nvidia H100'den %60'a kadar daha hızlı

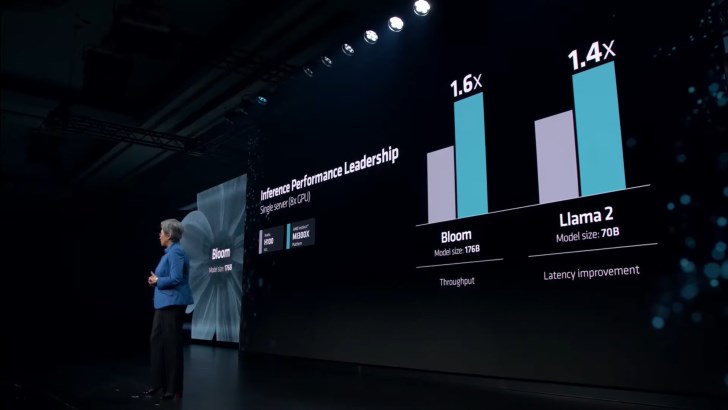

MI300X genel olarak büyük dil modeli (LLM) çekirdek TFLOPs'da H100'den %20'ye kadar daha iyi performans sergiliyor. Platform ölçeğinde ise 8 tane MI300X ile 8 adet H100 kıyaslandığında fark daha da açılarak Llama 2 70B'de %40, Bloom 176B'de %60'a kadar daha yüksek performans sergiliyor.

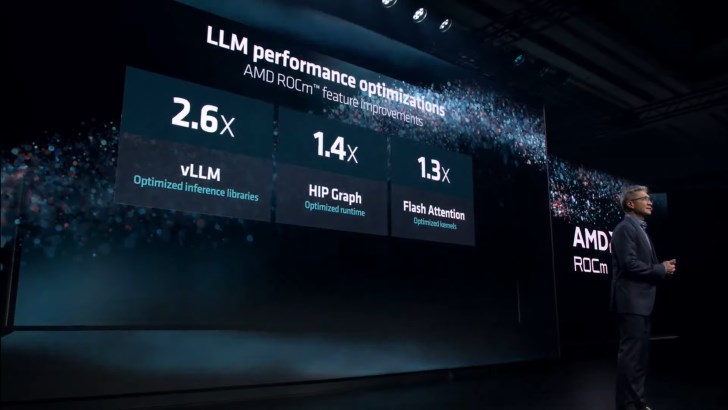

MI300'ün arkasında bulunan güç ROCm 6.0 yazılım kümesi. Çeşitli AI iş yüklerine destek sunan yazılım güncellendi. Yeni yazılım kümesi, FP16, Bf16 ve FP8 (Sparity dahil) gibi en yeni hesaplama formatlarını destekliyor. Yapılan optimizasyonlar sonucu, vLLM'de 2,6 kat, HIP Graph'ta 1,4 kat, Flash Attention'da 1,3 kata kadar hız artışı gerçekleşiyor. ROCm 6'nın bu ayın sonlarında MI300 AI hızlandırıcılarla birlikte sunulması bekleniyor.

153 milyar transistör içeriyor

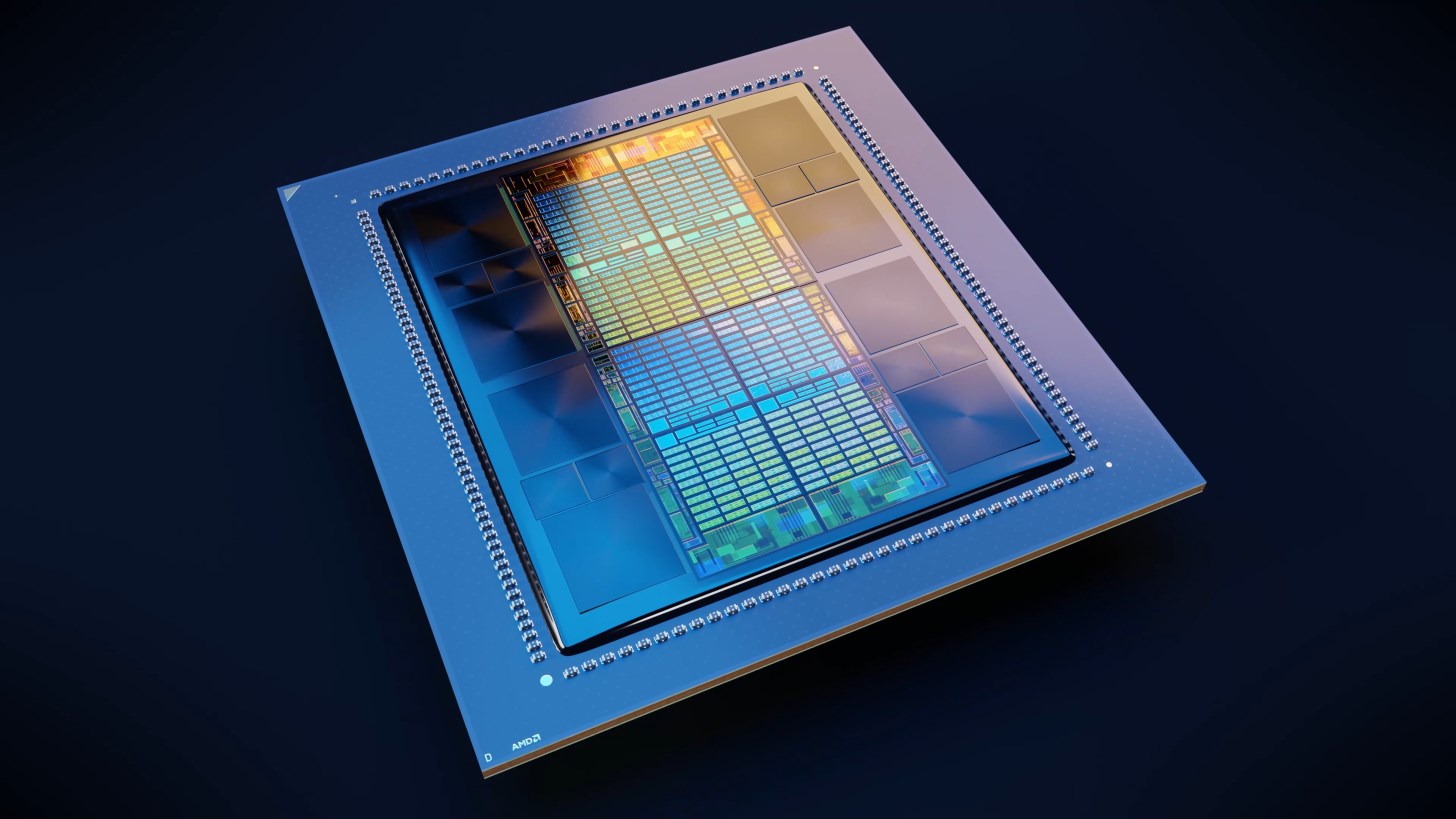

AMD Instinct MI300X, CDNA 3 mimarisiyle tasarlandı. 5nm ve 6nm bölümlere sahip çipte 153 milyar transistör bulunuyor.

CDNA 3 GPU mimarisini temel alan her bir hesaplama zarı (GCD), 2560 çekirdeğe karşılık gelen toplam 40 işlem birimine sahip. 8 adet GCD bulunuyor. Yani toplamda 320 hesaplama ve 20.480 çekirdek ünitesi bulunuyor. Verim açısından, AMD bu çekirdeklerin küçük bir kısmının ölçeğini küçültecek ve toplam 19.456 akış işlemcisi için toplam 304 hesaplama birimi (GPU yongası başına 38 CU) kullanacak.

%50 daha fazla bellek

MI300X, bellek alanında da büyük bir artış ile geliyor. Önceki hızlandırıcı MI250X'den %50 daha fazla olan 192GB belleğe sahip. Yeni bellekler 5.3 TB/s bant genişliği ve 896 GB/s Infınity Fabric bant genişliğine sahip. Kıyaslama açısından Nvidia H200 141 GB belleğe, Intel Gaudi 3 ise 144 GB belleğe sahip.

- Instinct MI300X - 192 GB HBM3

- Gaudi 3 - 144 GB HBM3

- H200 - 141 GB HBM3e

- MI300A - 128 GB HBM3

- MI250X - 128 GB HBM2e

- H100 - 96 GB HBM3

- Gaudi 2 - 96 GB HBM2e

Güç tüketiminde ise MI300X, önceki nesil MI250X'den %50 daha fazla olan 750 Watt tüketime sahip. Nvidia H200'den ise 50 Watt daha yüksek.

2024'de Nvidia Hopper H200 ve Blackwell B100 GPU'larını, Intel ise Guadi 3 ve Falcon Shores GPU'larını piyasaya sürecek. Yapay zeka alanında rekabet kızışırken, AMD Nvidia'nin hakimiyetini kırmak için çaba gösteriyor. Şirketler piyasa var olan her türlü AI çözümününü silip süpürdüklerinden dolayı AMD'nin yeni hızlandırıcılarının da kendine iyi bir yer edineceğini söylemek zor değil.

Bu haberi, mobil uygulamamızı kullanarak indirip,istediğiniz zaman (çevrim dışı bile) okuyabilirsiniz:

İnce Satırlar

İnce Satırlar Liste Modu

Liste Modu Döşeme Modu

Döşeme Modu Sade Döşeme Modu

Sade Döşeme Modu Blog Modu

Blog Modu Hibrit Modu

Hibrit Modu