Yapay zekanın anlaşılamayan dünyası

Günümüzde yapay zekanın temelini oluşturan büyük dil modelleri, insan dilini anlamak ve üretmekte olağanüstü bir başarı gösterse de, bu modellerin karar verme süreçleri büyük ölçüde gizemini koruyor. Bir modele hangi komutların verildiğini ve ne tür yanıtlar ürettiğini görebiliyoruz; ancak bu yanıtların nasıl oluşturulduğunu anlamak hala belirsizliğini koruyor.

Bu bilinmezlik, yapay zeka uygulamalarında güven sorunlarına yol açıyor. Modellerin, hatalı bilgiler üretme (halüsinasyon) eğilimlerini önceden tahmin etmek zorlaşıyor. Ayrıca, bazı kullanıcılar tarafından modellerin güvenlik önlemlerini aşmak için uygulanan "jailbreak" tekniklerinin neden bazı durumlarda işe yaradığı hala tam olarak açıklanamıyor.

Anthropic araştırmacıları, bu karmaşık yapıyı çözümlemek için büyük bir adım attı. İnsan beynini incelemek için kullanılan fMRI teknolojisinden ilham alan ekip, büyük dil modellerinin iç işleyişini anlamaya yönelik yeni bir araç geliştirdi. Bu teknik, yapay zeka modellerinin "beyinlerini" haritalandırarak hangi süreçlerin devreye girdiğini ortaya koyuyor.

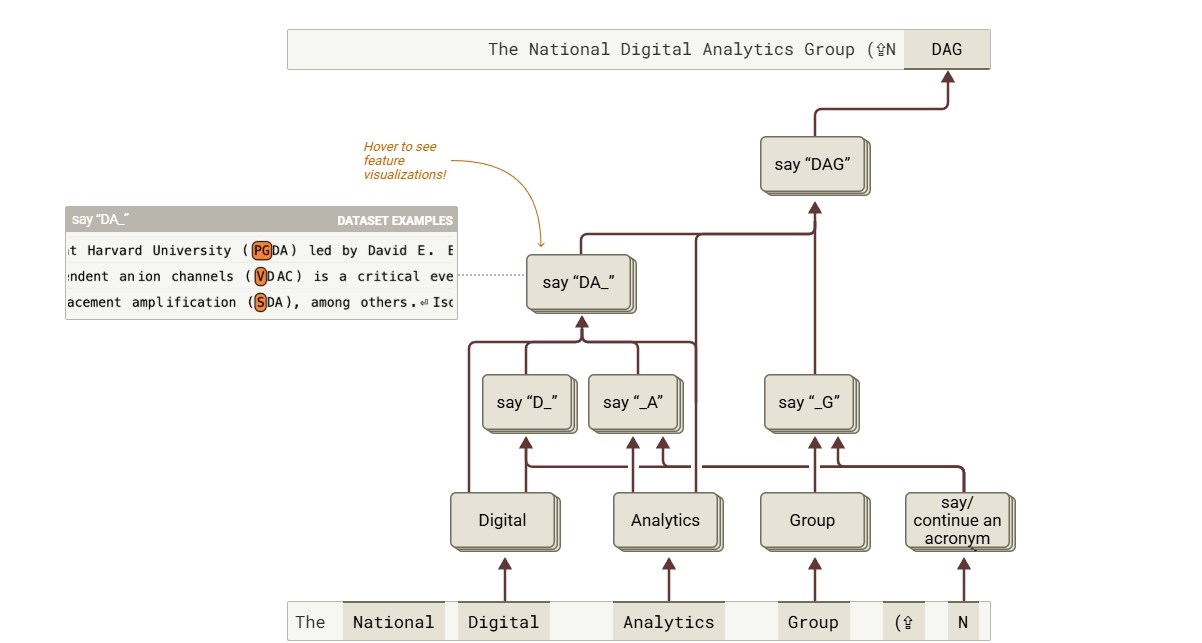

Bu yeni aracı Claude 3.5 Haiku modeline uygulayan araştırmacılar, yapay zekanın bilinçli olmasa bile planlama ve mantıksal çıkarım yapabildiğini gösterdi. Örneğin, bir şiir yazma görevi verildiğinde modelin, uyumlu kelimeleri önceden belirleyip ardından bu kelimelere uygun cümleler kurduğu gözlemlendi.

Araştırmanın bir diğer dikkat çekici bulgusu ise dil modellerinin çok dilli çalışmasındaki mantık yapısı oldu. Claude modeli, farklı dillerde ayrı bileşenler kullanmak yerine, tüm diller için ortak kavramsal bir alan kullanarak çalışıyor. Yani model, önce soyut kavramlar üzerinden bir akıl yürütme sürecine giriyor ve ardından bu düşünceyi istenilen dile çeviriyor.

Bu bulgu, çok dilli yapay zekaların nasıl daha verimli hale getirilebileceğine dair yeni kapılar aralıyor. Özellikle küresel ölçekli yapay zeka çözümleri geliştiren şirketler için bu yaklaşım, modellerin daha tutarlı ve hızlı çalışmasını sağlayabilir.

Kara kutunun açılması neden önemli?

Öte yandan bazı uzmanlar göre LLM’lerin bu gizemli yapısı çok da büyük bir problem değil.

Bununla birlikte büyük dil modelleri (LLM'ler) ile ilgili sorun, çıktılara ulaşma yöntemlerinin insanların aynı görevleri yapma biçiminden oldukça farklı olması. Bu nedenle, bir insanın yapması pek olası olmayan hatalar yapabilirler.

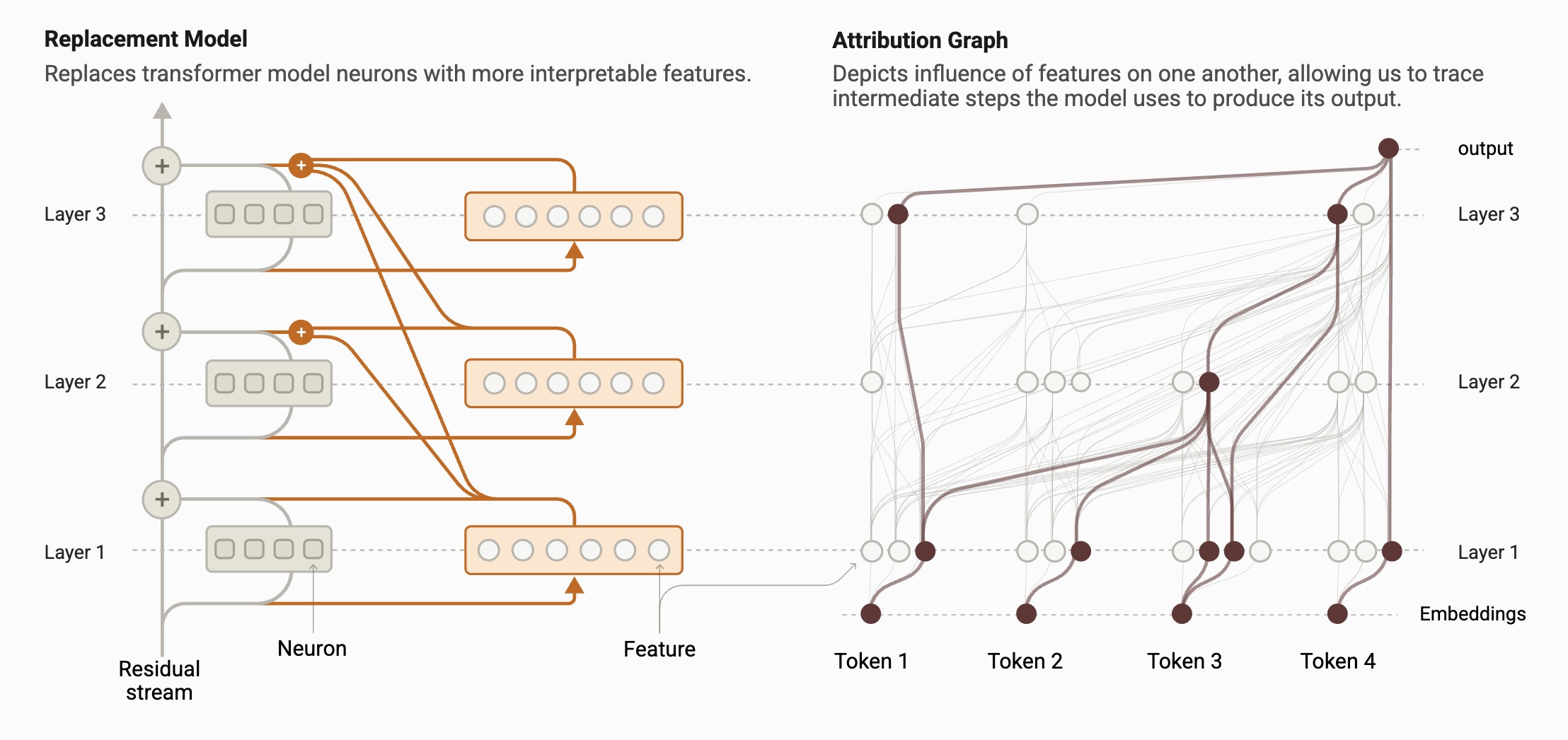

Cross-Layer Transcoder (CLT) yaklaşımı

Anthropic, bu sorunu aşmak için tamamen yeni bir model geliştirdi: Cross-Layer Transcoder (CLT). CLT, yapay zeka modelini bireysel nöron seviyesinde değil, yorumlanabilir özellik kümeleri seviyesinde analiz ediyor. Örneğin, belirli bir fiilin tüm çekimleri veya “daha fazla” anlamına gelen tüm terimler tek bir özellik kümesi olarak ele alınabiliyor. Bu sayede, araştırmacılar modelin belirli bir görevi yerine getirirken hangi nöron gruplarının birlikte çalıştığını görebiliyor. Ayrıca, bu yöntem araştırmacılara sinir ağı katmanları boyunca modelin akıl yürütme sürecini takip etme olanağı sağlıyor.

Anthropic ayrıca, ağın devrelerini analiz etmenin oldukça zaman alıcı olduğunu vurguladı. Yalnızca "onlarca kelimeden" oluşan kısa girdiler için bile bir insan uzmanının birkaç saatini alabiliyor. Yöntemin çok daha uzun girdilere nasıl ölçeklenebileceği ise belirsizliğini koruyor. Ancak yine de CLT, Pandora’nın kutusunu açmak için atılmış son derece önemli bir adım.

Bu haberi, mobil uygulamamızı kullanarak indirip,istediğiniz zaman (çevrim dışı bile) okuyabilirsiniz:

İnce Satırlar

İnce Satırlar Liste Modu

Liste Modu Döşeme Modu

Döşeme Modu Sade Döşeme Modu

Sade Döşeme Modu Blog Modu

Blog Modu Hibrit Modu

Hibrit Modu

ÇÖP