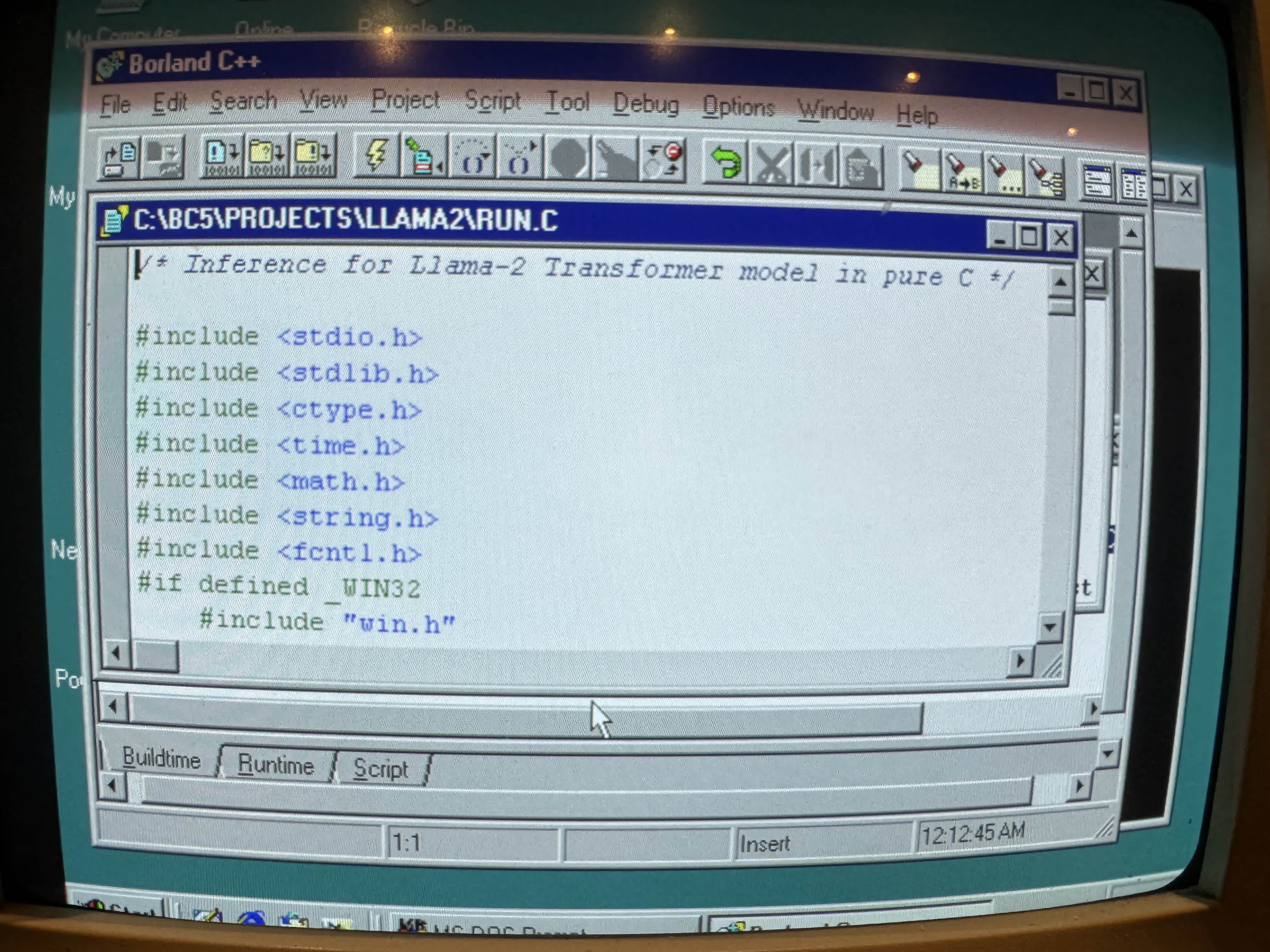

EXO Labs, bu deneyimi bir video ile sosyal medya platformu X'te paylaştı. Videoda, tozlanmış bir Elonex Pentium II sistemine yüklenen Llama2.c tabanlı bir modelin, bir hikaye oluşturma komutunu başarıyla yerine getirdiği görüldü. Üstelik hız açısından da tatmin edici bir performans sergiledi.

Başarı büyük, amaç farklı

Ekibin karşılaştığı en büyük zorluklardan biri, 1998 yılına ait bir işletim sistemi üzerinde modern bir yapay zeka modelini derleyip çalıştırmaktı. Ancak bu zorlukların üstesinden gelerek 260.000 parametreli bir LLaMA modelini saniyede 39.31 token işleme hızında çalıştırmayı başardılar. Daha büyük modellerde ise performans kaybı yaşandı; örneğin, 1 milyar parametreli bir model saniyede sadece 0.0093 token hızına ulaşabildi.

EXO Labs, "BitNet" adını verdikleri bir transformer mimarisi üzerinde çalışıyor. Bu teknoloji, model boyutunu küçültmek için üçlü ağırlıklar (ternary weights) kullanıyor ve 7 milyar parametreli bir modeli sadece 1.38GB depolama alanında çalıştırmayı mümkün kılıyor. Daha da etkileyici olan ise, BitNet'in yalnızca CPU ile çalışmak üzere tasarlanmış olması. Bu mimari, 100 milyar parametreli bir modeli tek bir CPU üzerinde, saniyede 5-7 token işleme hızında çalıştırabiliyor.

Bu haberi, mobil uygulamamızı kullanarak indirip,istediğiniz zaman (çevrim dışı bile) okuyabilirsiniz:

İnce Satırlar

İnce Satırlar Liste Modu

Liste Modu Döşeme Modu

Döşeme Modu Sade Döşeme Modu

Sade Döşeme Modu Blog Modu

Blog Modu Hibrit Modu

Hibrit Modu

ChatGPT doğru dinin İslam olduğunu söylüyor zaten.

Joe bidenden iyi yürüyo